在信息爆炸的数字化时代,我们每天在工作中接触的文档、笔记、案例等资料呈指数级增长。研究表明,普通职场人每年因信息检索低效造成的有效工作时间损失高达150小时。而一个智能化的个人知识库,正是解决以下痛点的最佳方案,他可以让我们告别信息碎片化、解锁高效的工作流、还可以构建专属知识体系。

今天我们就来教大家如何利用最近爆火的Deepseek来搭建一个属于你自己的知识库,搭建知识库有两种方案:本地化部署大模型、API调用。

本地部署 vs API调用

| 对比维度 | 本地部署(如Ollama) | API调用(如DeepSeek官方API) |

|---|---|---|

| 核心原理 | 模型完全运行在本地服务器/电脑 | 通过互联网调用云端大模型 |

| 数据流向 | 数据不出内网,全程本地处理 | 文件需上传至第三方服务器 |

| 硬件要求 | 需高性能GPU(如RTX 4090),显存越大越好 | 普通电脑即可(依赖网络) |

| 响应速度 | 无需网络传输,实时响应(但受硬件限制) | 依赖网络质量,百毫秒级延迟 |

| 部署难度 | 需配置Docker/虚拟环境,技术门槛高 | 安装软件+复制API密钥,小白10分钟搞定 |

| 成本对比 | ▶ 前期投入高:显卡+服务器 ▶ 后期维护成本低 | ▶ 零硬件投入 ▶ 按调用量付费 |

| 隐私安全 | 军工级防护,适合法律/医疗等敏感数据 | 存在第三方数据泄露风险 |

| 模型能力 | 多为精简版模型(如1.5B/7B参数) | 使用完整版大模型(如671B参数) |

| 典型场景 | 律师事务所/医院/金融机构内部系统 | 个人学习/小微企业/临时项目 |

选择建议

- 选本地部署:

- 当处理合同、病历等涉密文件时

- 企业有长期稳定需求且IT团队较强

- 案例:某律所部署本地知识库后,合同审查效率提升65%

- 选API调用:

- 个人用户/初创公司预算有限

- 需要最新模型能力(如实时联网搜索)

- 案例:自由职业者用API方案,3小时完成全年资料归档

关于如何本地部署大模型,可参考我们上一篇的教程(文章第三部分教你如何通过ollama部署deepseek大模型),今天我们主要分享通过API调用的方式来部署本地个人知识库。

一、环境准备

- 下载安装Cherry Studio

- 访问Cherry Studio官网:https://cherry-ai.com/,选择对应操作系统(Windows/Mac/Linux)版本下载

- 下载完成后安装软件,首次启动界面包含智能体管理和知识库入口

- 访问Cherry Studio官网:https://cherry-ai.com/,选择对应操作系统(Windows/Mac/Linux)版本下载

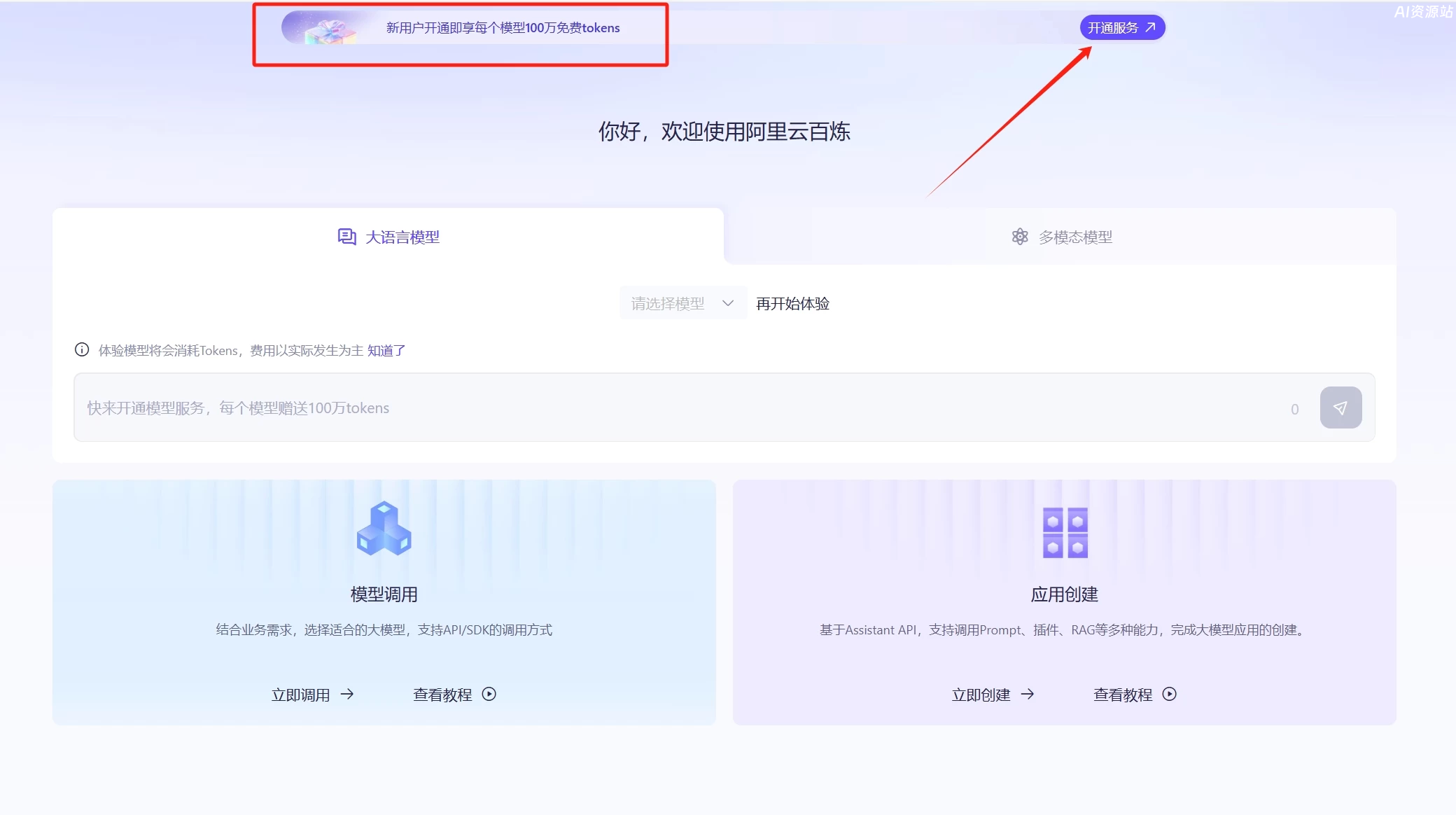

- 注册阿里云百炼账号

- 访问阿里云百炼官网:https://bailian.console.aliyun.com/#/model-market

- 可用阿里云账号直接登录,你也可以直接注册,新用户每个模型赠送100万Tokens。当然你也可以使用其他平台的API,比如deepseek官网、腾讯、百度等平台,我们在上一篇教程中也做了推荐(点击直达)

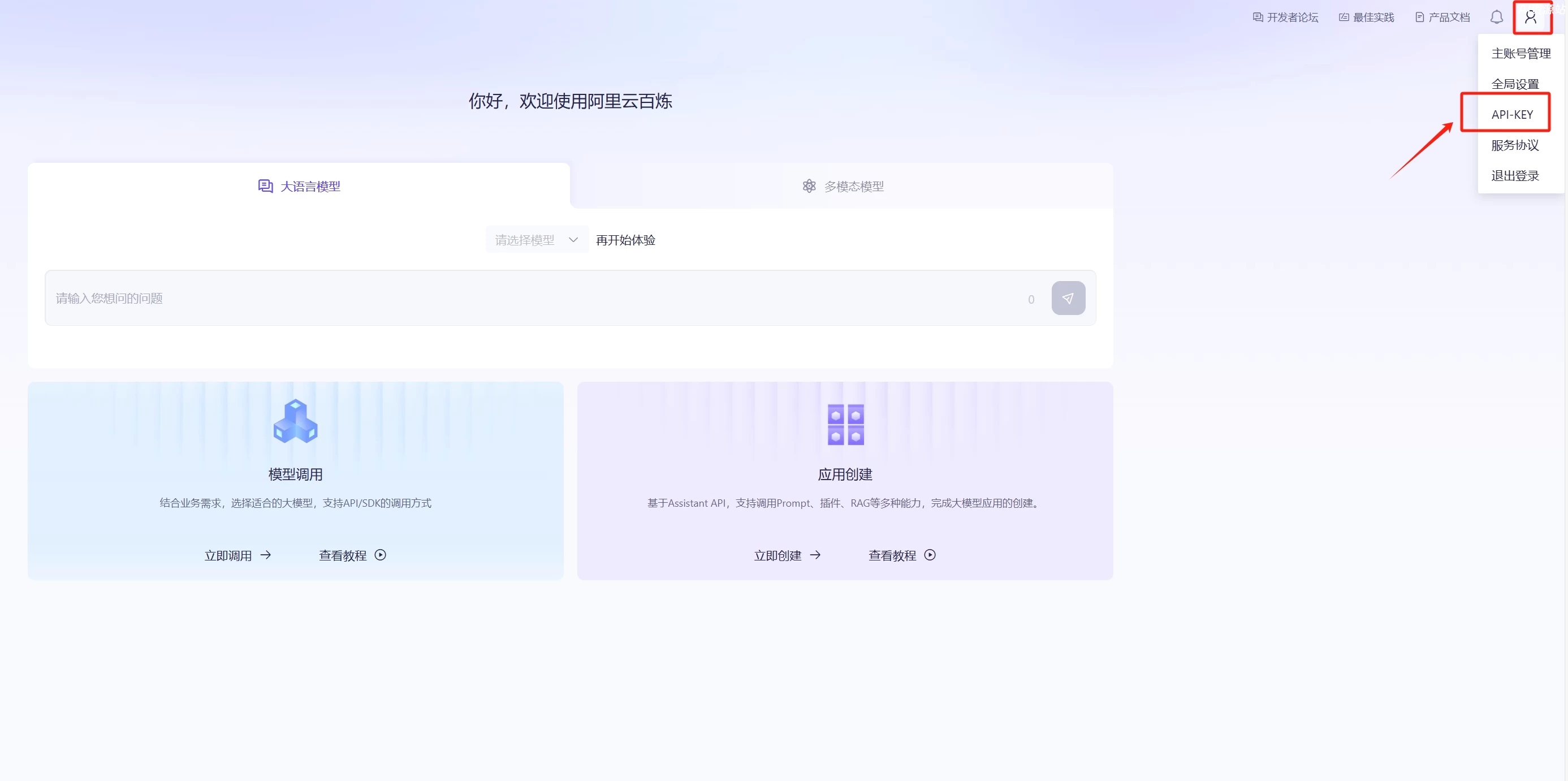

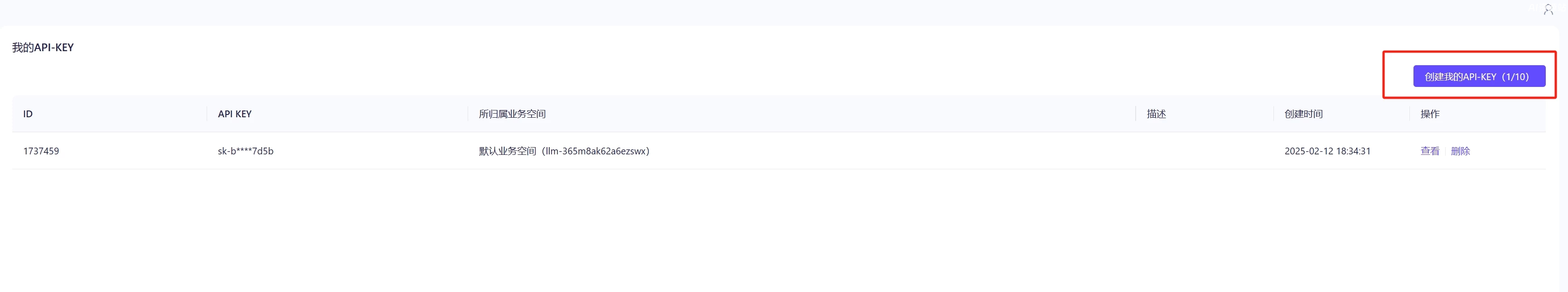

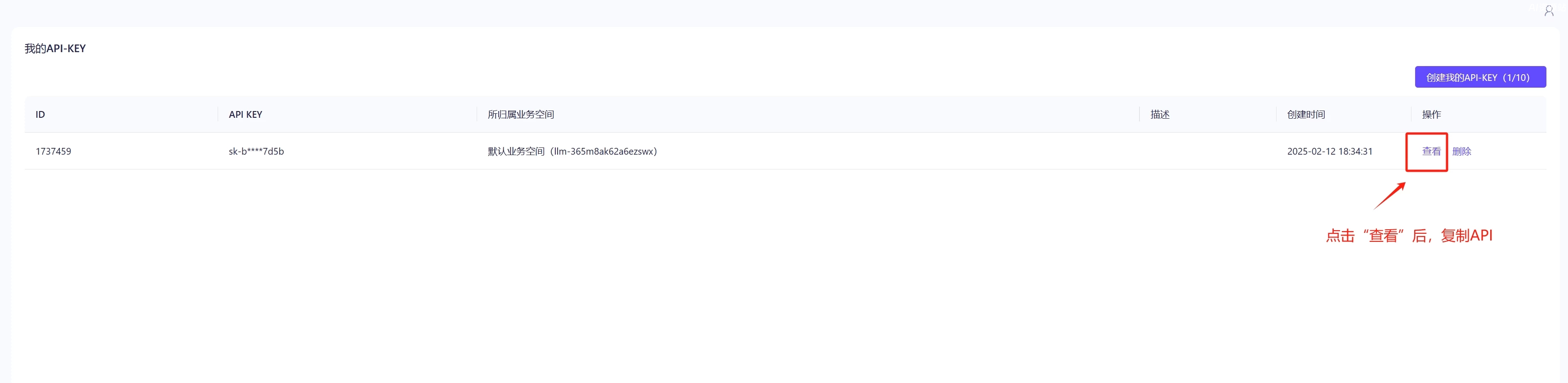

- 开通完成后,点击右上角账号管理中的“API-KEY”,创建你的API-KEY

- API创建完成后,复制API

二、配置Deepseek模型

- 添加模型到Cherry Studio

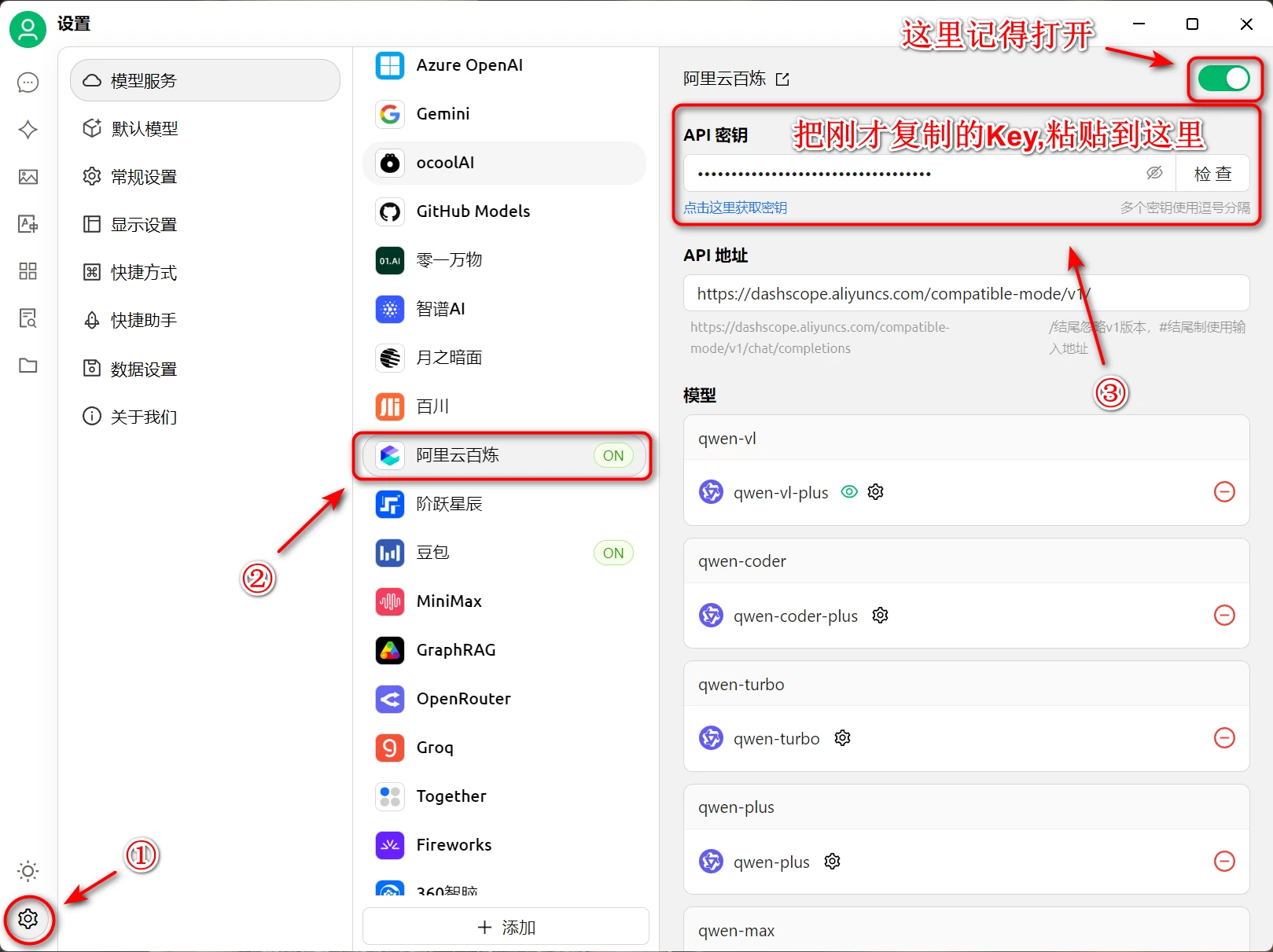

- 打开Cherry Studio,点击左下角设置

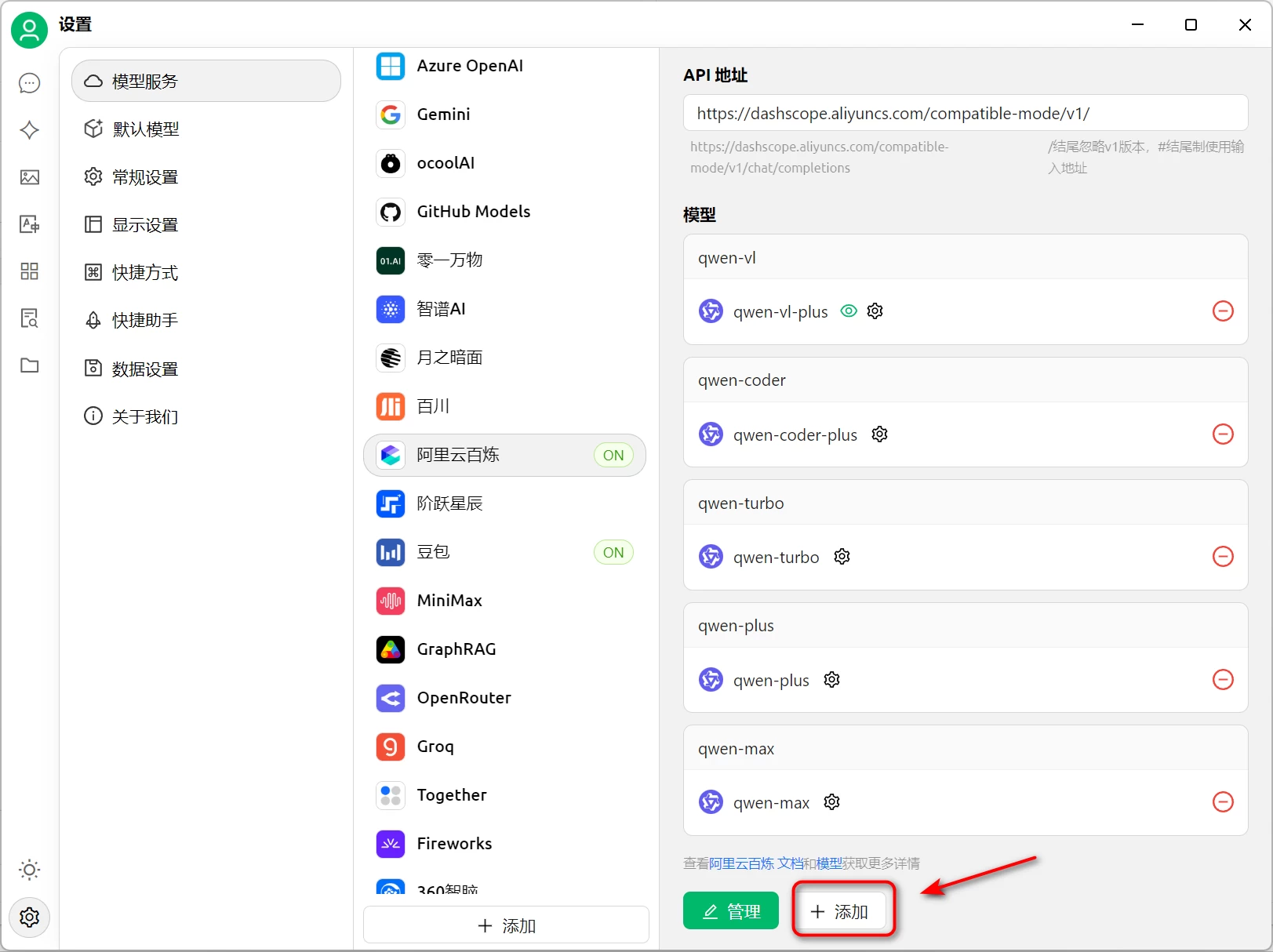

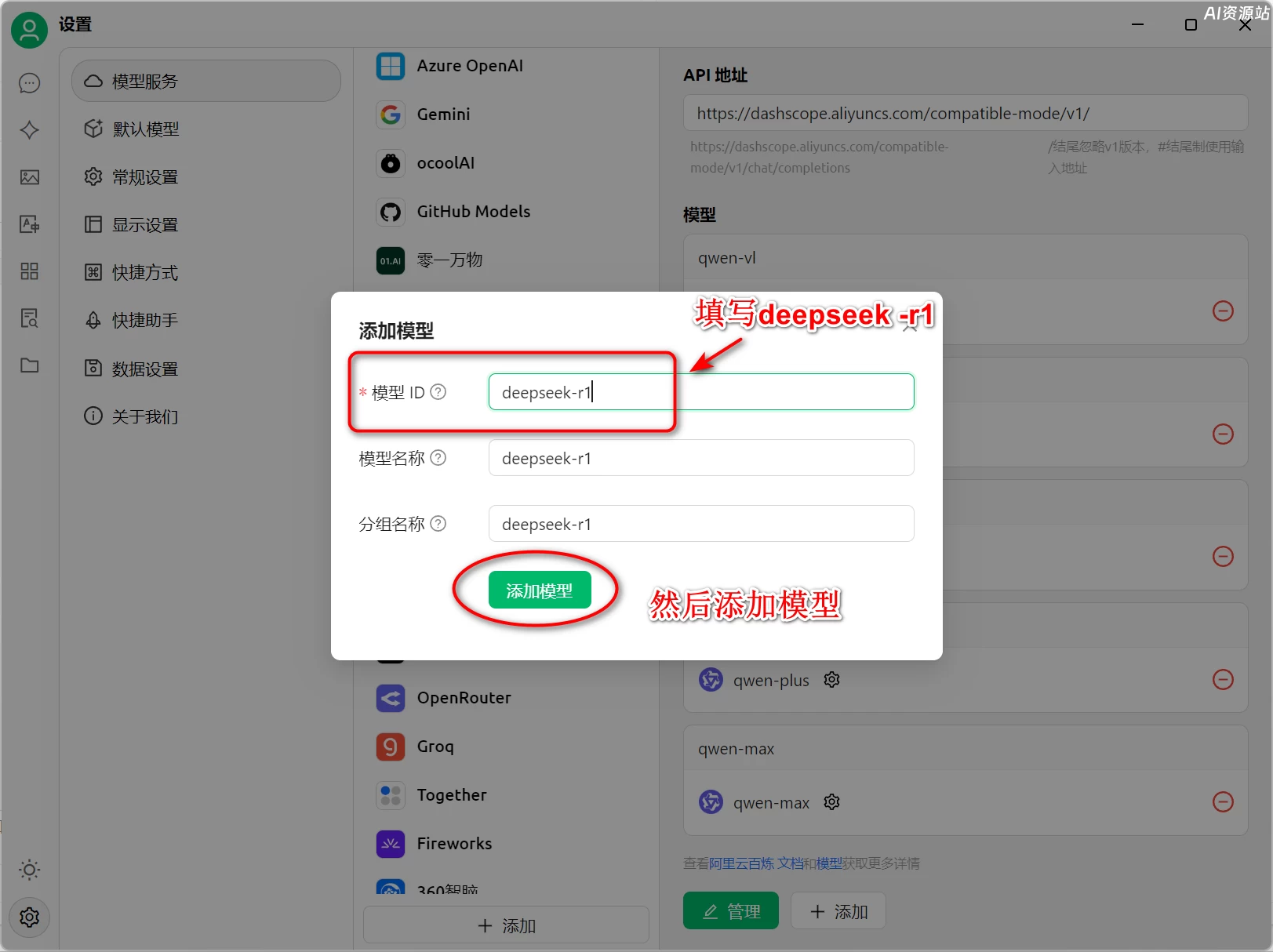

- 接下来我们来添加deepseek-r1模型

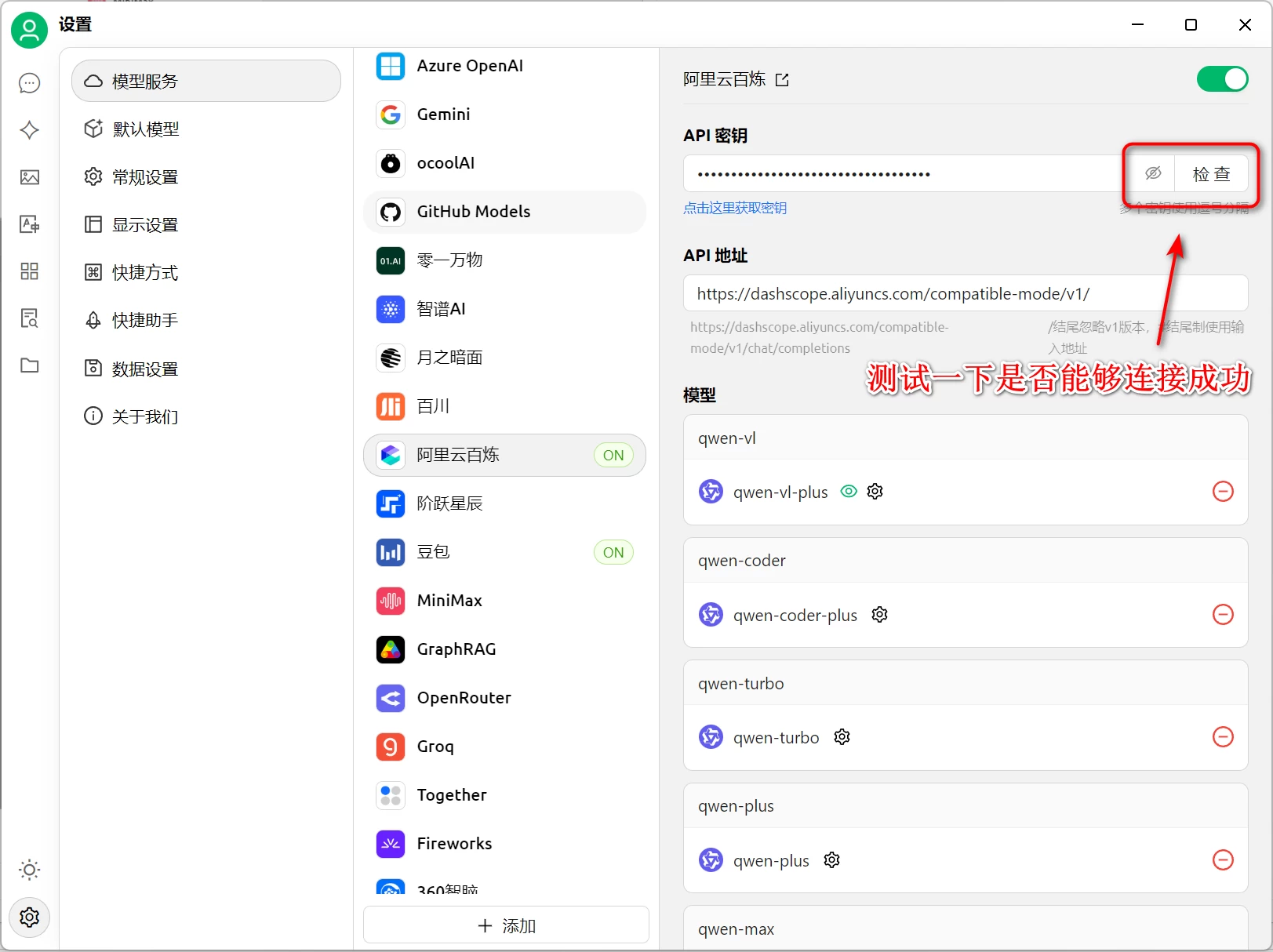

- deepseek-r1模型添加好后,我们来测试一下是否能够连接成功

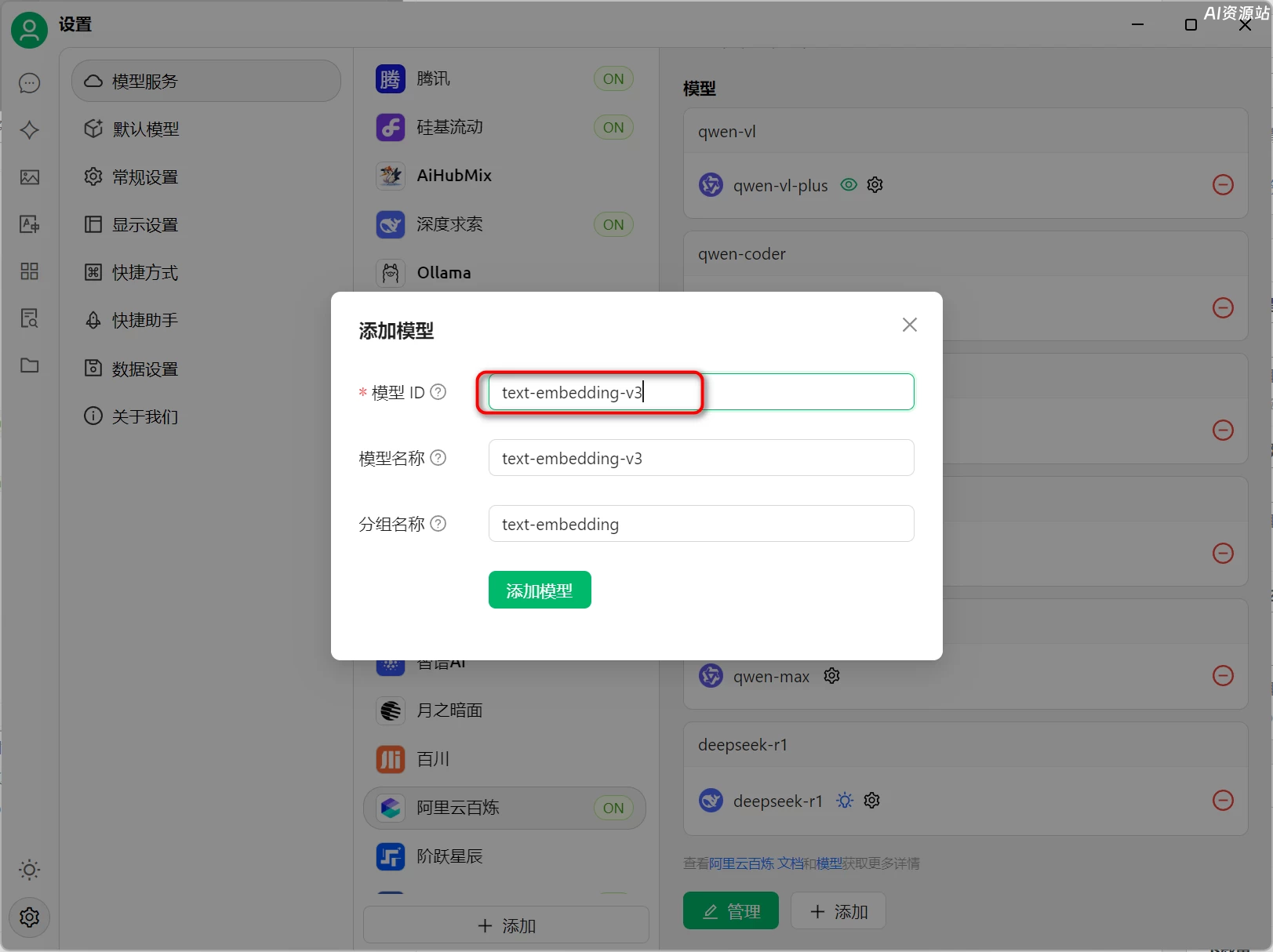

- 然后我们还要添加一个向量模型,这个主要是为我们的知识库文本类数据提供高效的向量化转换服务,适用于RAG、文本分类、情感分析等自然语言处理任务。这里我们添加的阿里云的向量模型text-embedding-v3,免费额度50万tokens,模型调用费用:0.0007元/千Token

- 继续点击“添加”模型,模型ID填写:text-embedding-v3

- 打开Cherry Studio,点击左下角设置

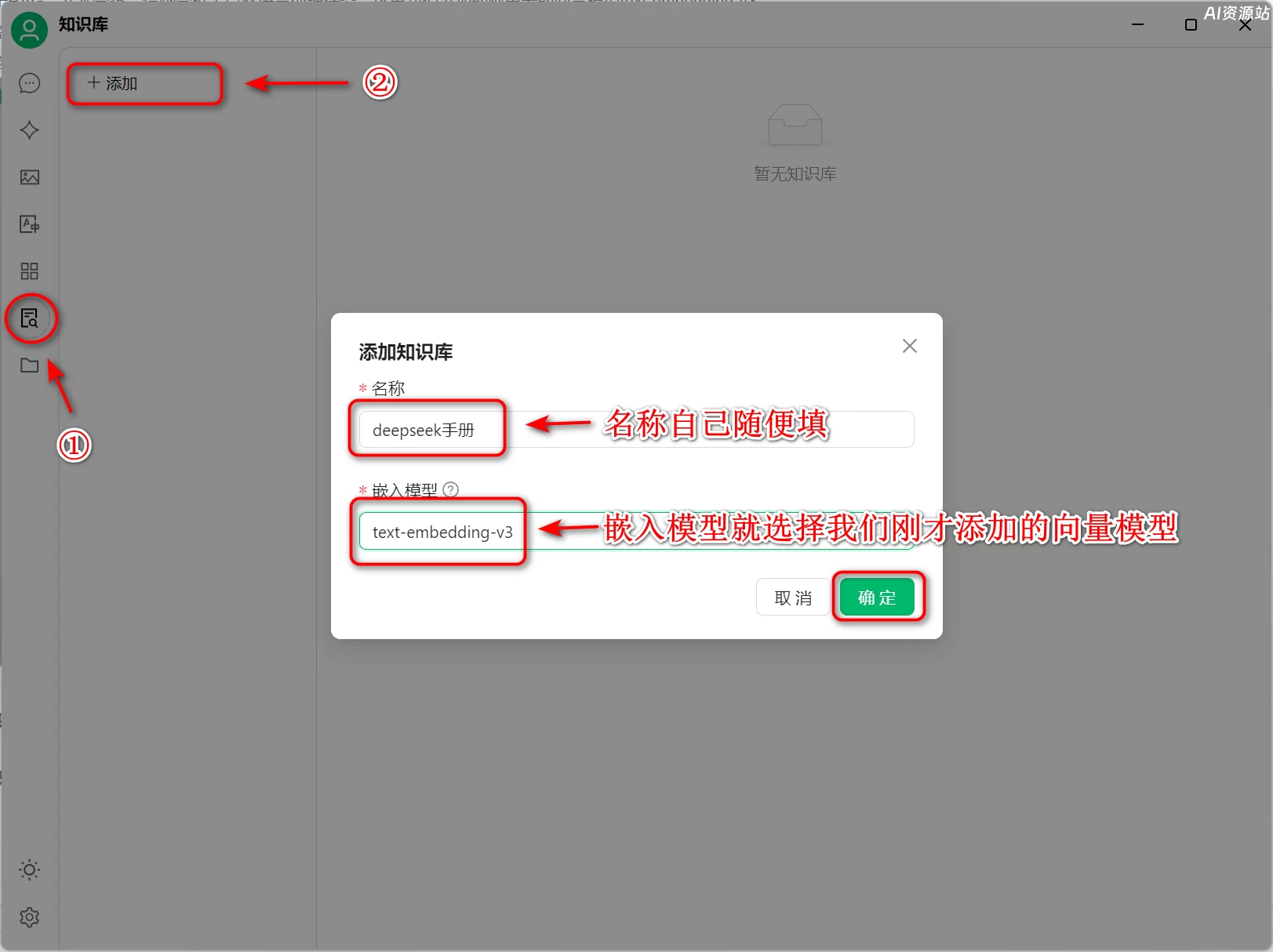

三、配置知识库

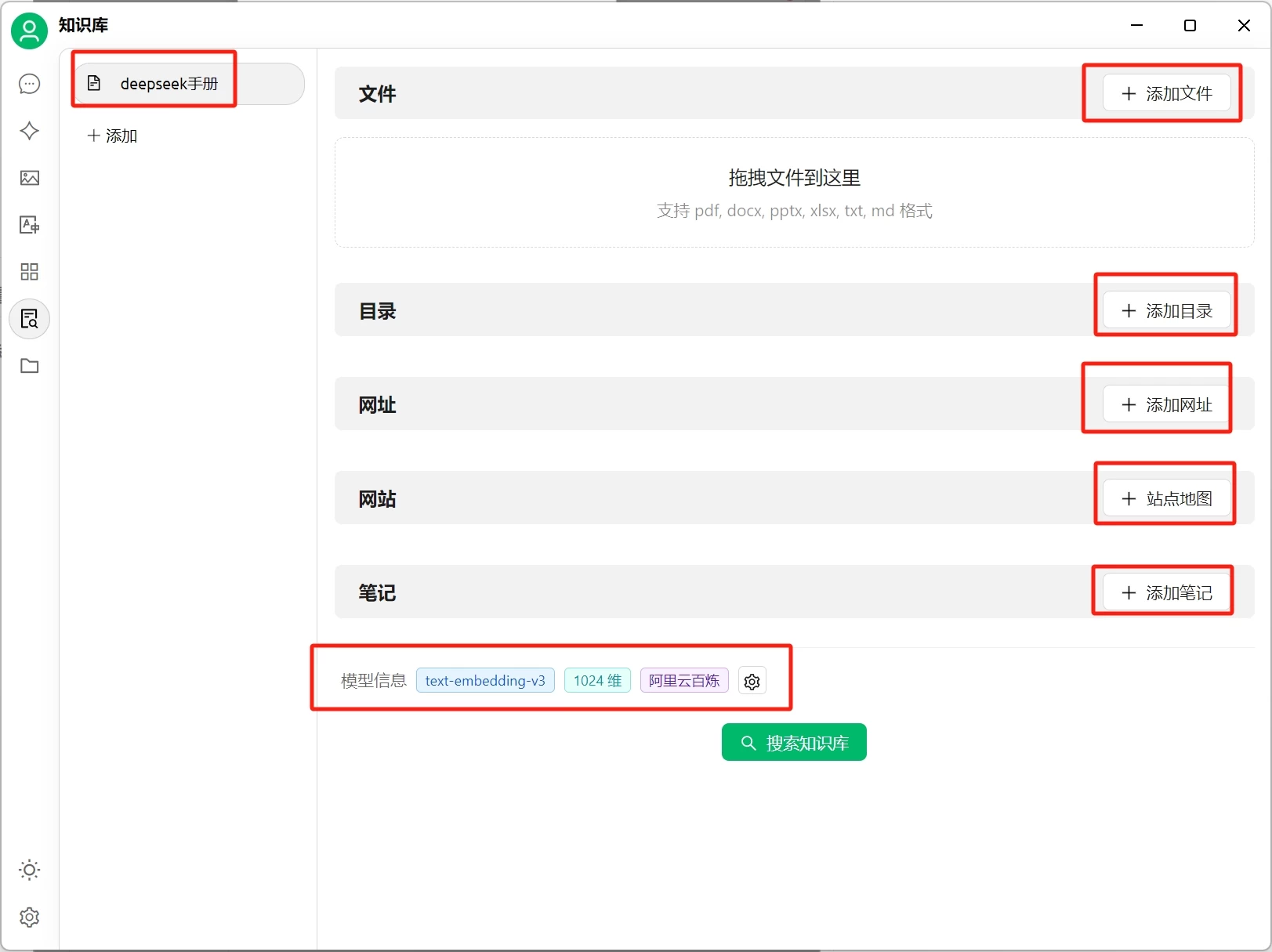

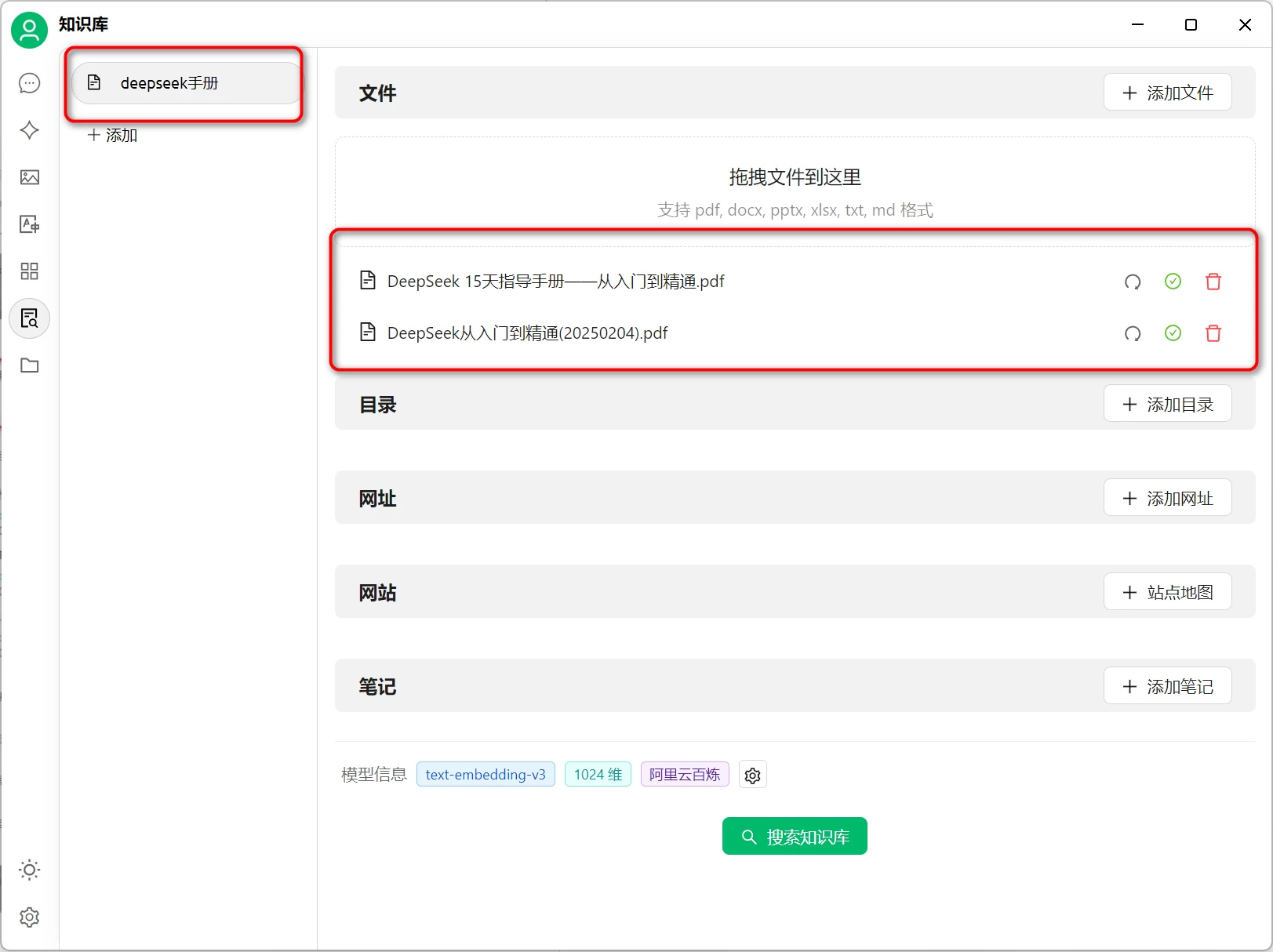

1.添加知识库,点击知识库入口的按钮

你可以添加文件、文件夹目录、网址、网站地图(sitemap)、笔记等内容到知识库中,下方还有刚刚我们添加的向量模型信息。

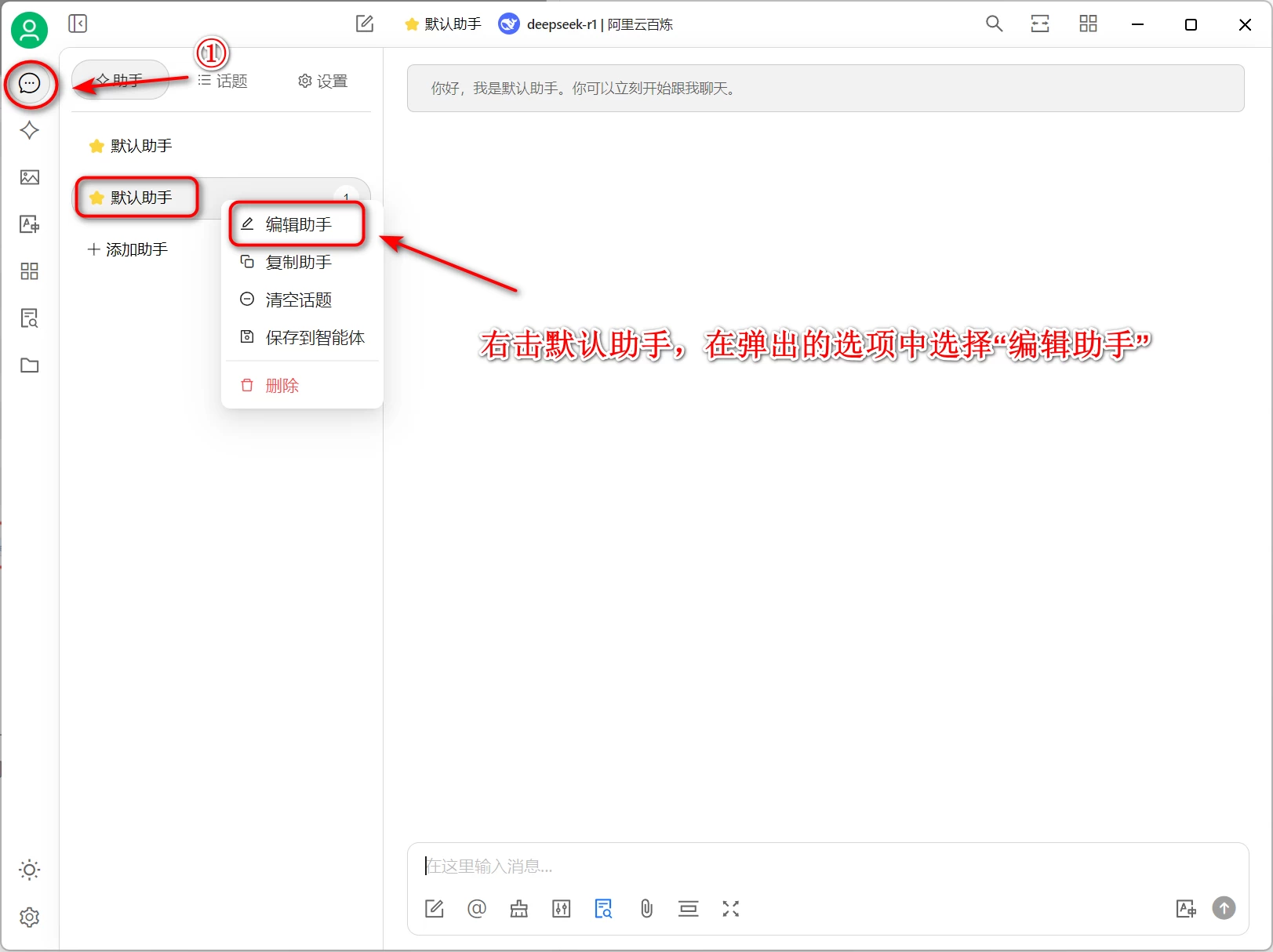

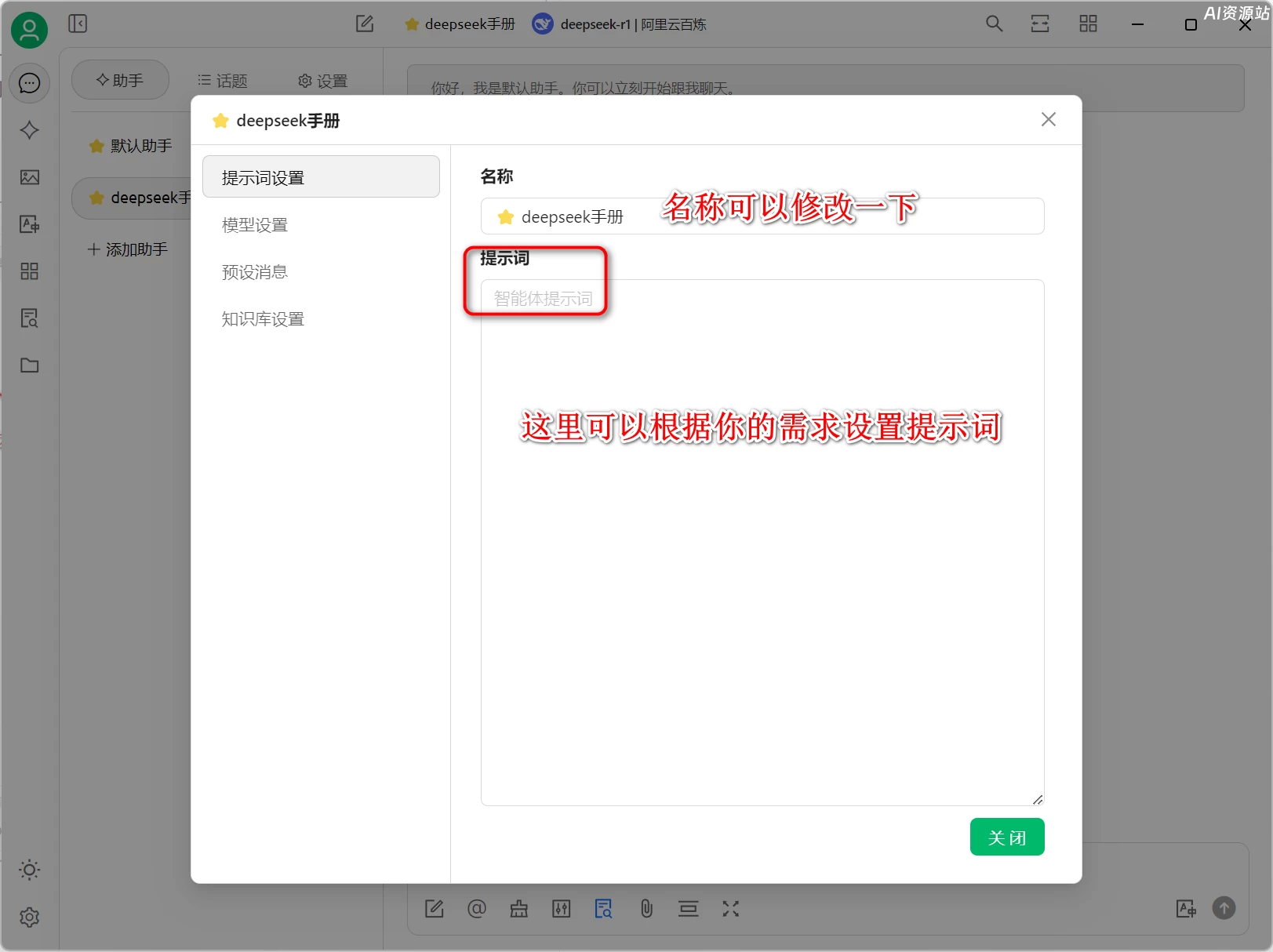

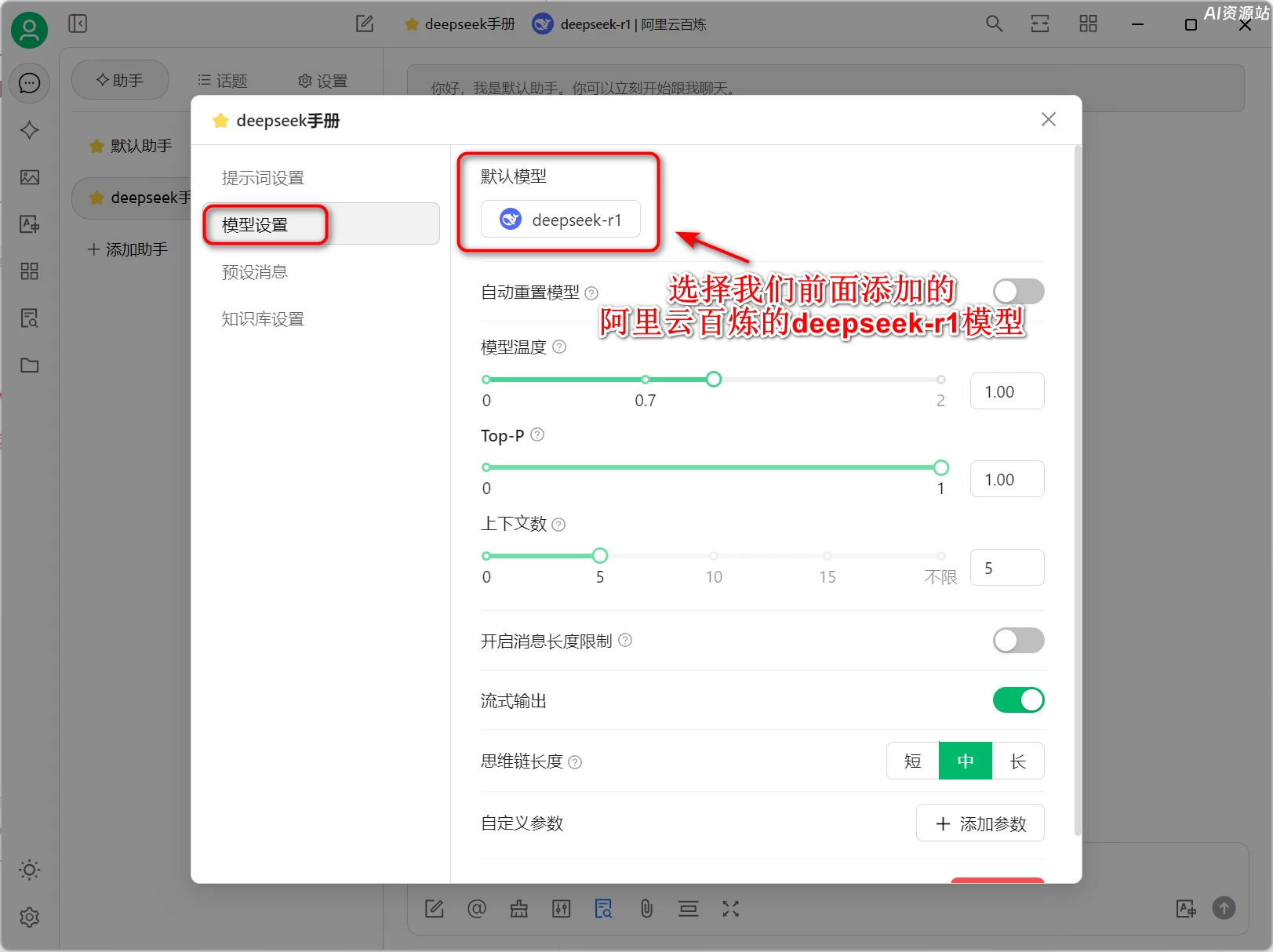

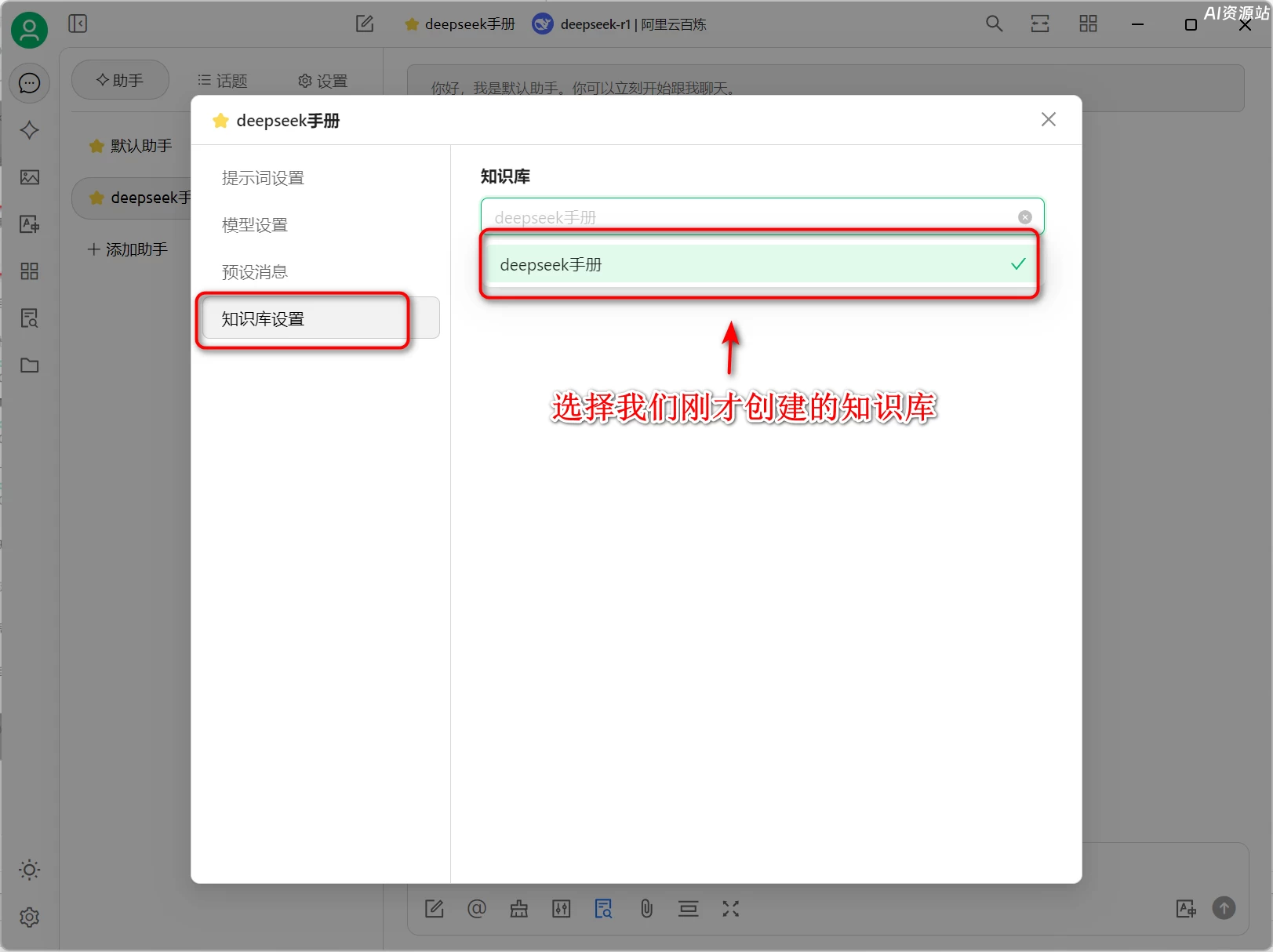

2.配置知识库助手

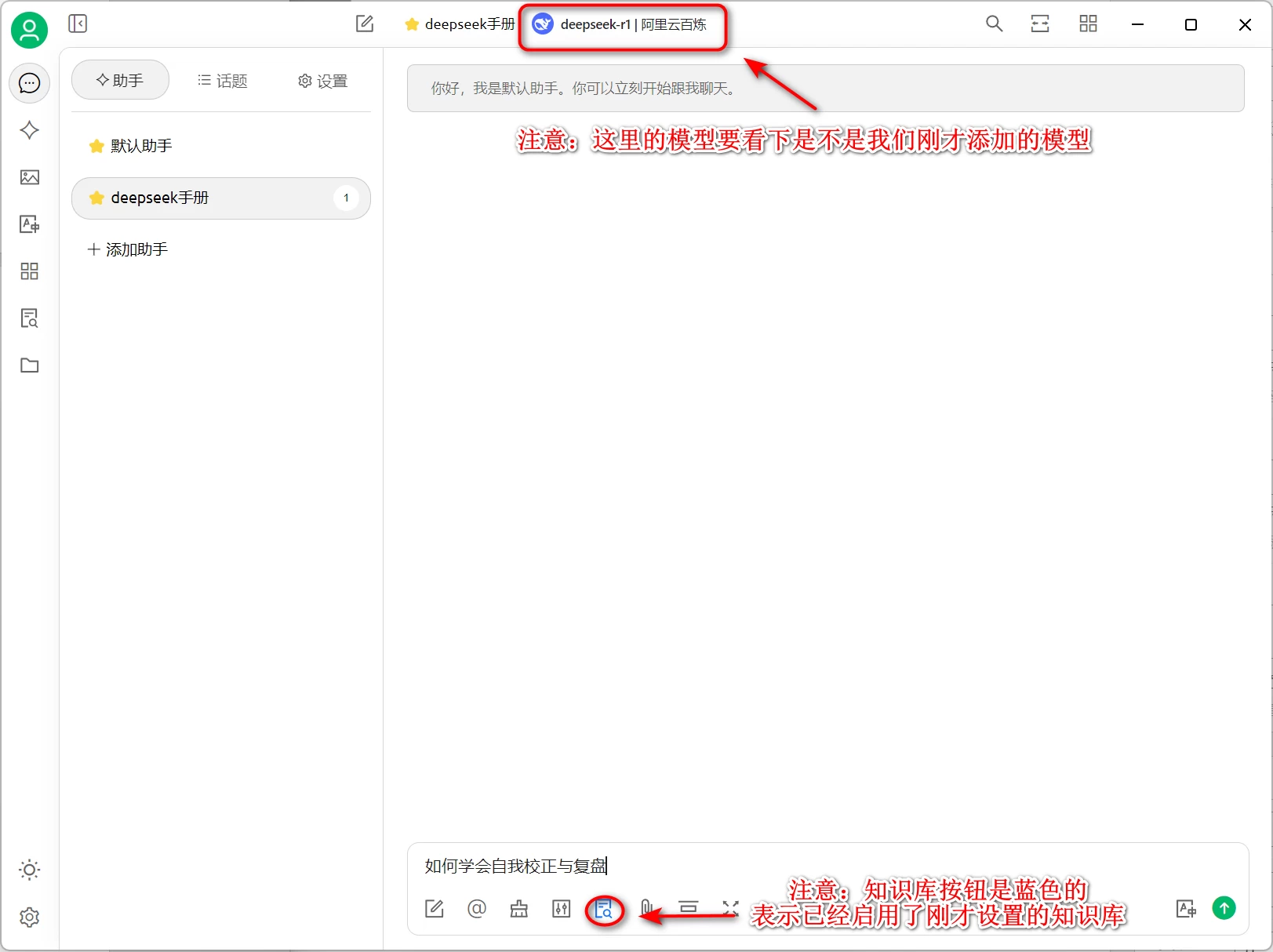

现在我们就可以正常使用知识库了

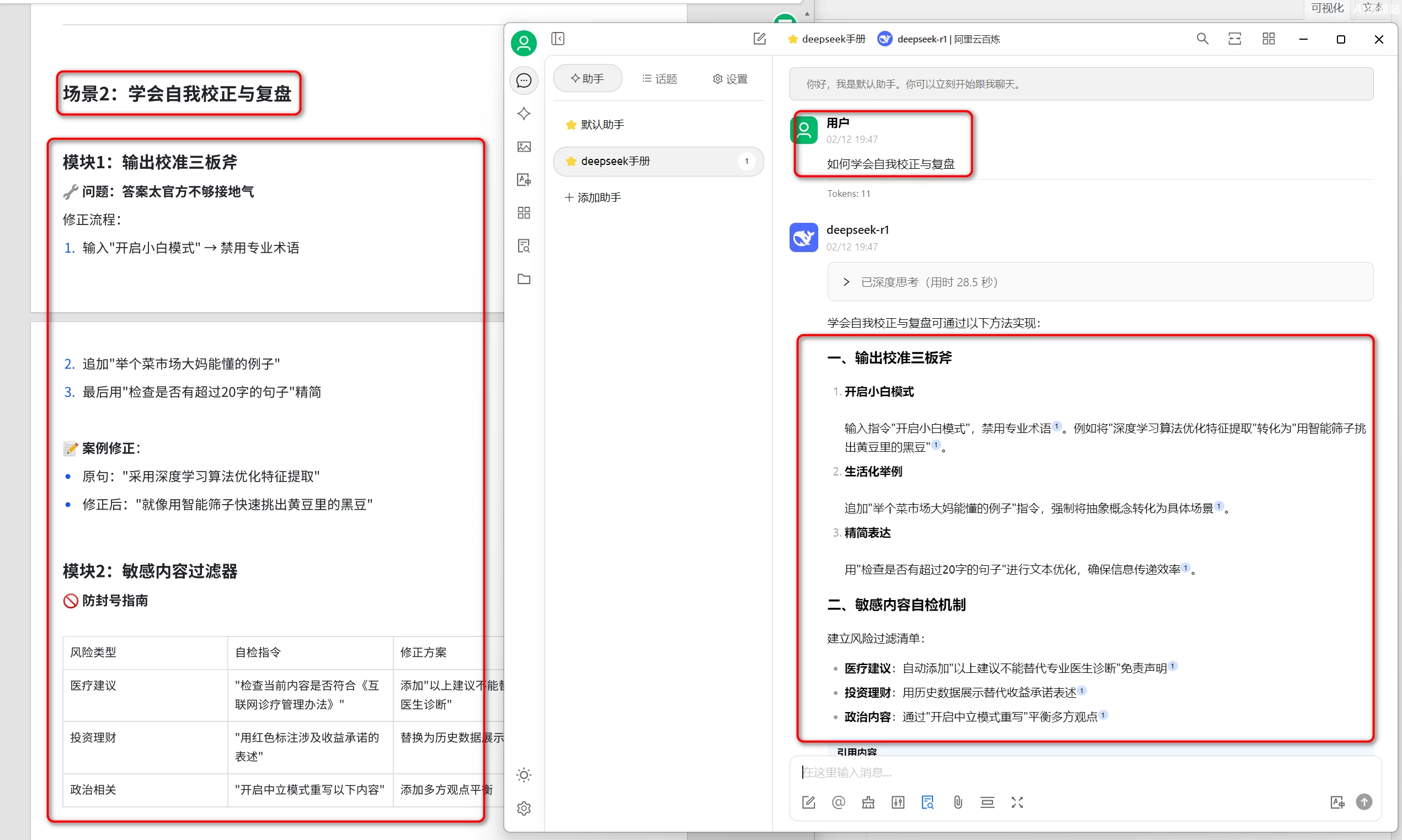

我们来简单检测一下,比如我们问助手“如何学会自我校正与复盘”,这也是我们添加在知识库中文档里的内容,我们可以看到所有的回复内容都是来自于我们的文档中

通过以上步骤,你已经成功搭建了一个基于DeepSeek R1与Cherry Studio的本地知识库系统!无论是企业管理、技术文档还是个人知识整理,这套方案都能帮助你快速实现智能化问答与信息检索。

🌟 记住:技术是工具,你的创造力才是关键!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...